Scroll down

search ie

WHAT DOES THE FUTURE HOLD?

Together with IE Insights, we’ve interviewed a selection of 50 thought leaders, authors and entrepreneurs, to find out how they envision the future of their disciplines. Some of them are available below, but head to the website to read the rest.

IE INSIGHTS

Discover the fascinating insights that emerge from our community of academics and industry experts, from research projects to podcasts, talks with guest speakers, and much more.

Germany, Chronicle of a Decline Foretold

The Unexpected Power of Everyday Workplace Interactions

How Soft Skills Shape Modern Leadership

WE ARE IE UNIVERSITY

Sustainability

As a leading higher-education institution, we’ve thought a lot about how tomorrow’s world will look and what kind of knowledge we must cultivate for our students to thrive in it. We are committed to fostering environmental and ethical stewardship as well as promoting increased awareness and public understanding.

DISCOVER OUR PROGRAMS

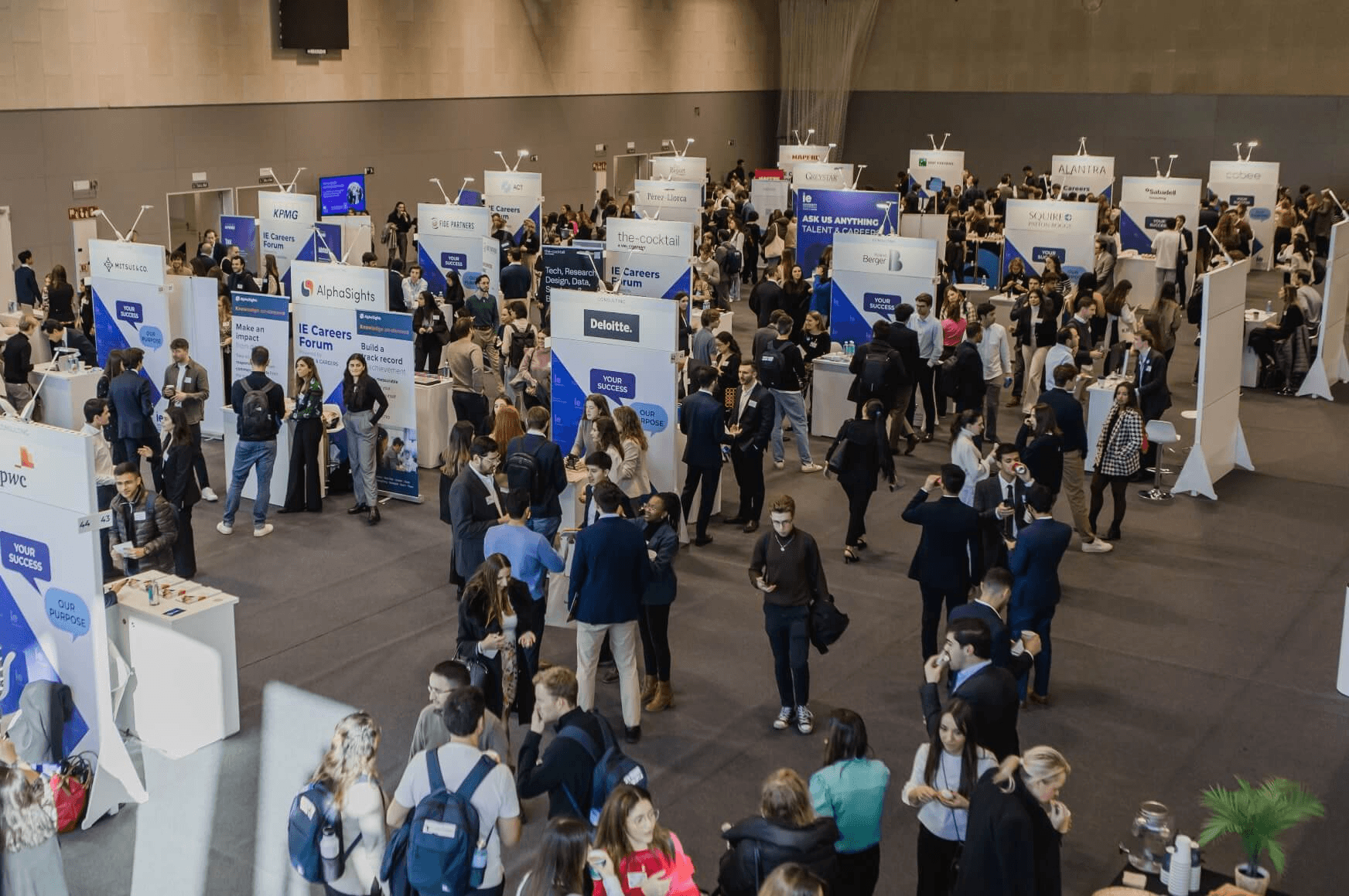

At IE University, we specialize in training future-forward leaders with a global vision, entrepreneurial mindset, and human-centered approach to driving innovation. By pushing the boundaries of higher education, our extensive global network of students and professors—further empowered by top institutional partnerships—are able to make a lasting impact in their field. Discover our diverse range of programs aimed at every different stage of the learning journey.

Admission process at IE University

Our rigorous admissions process is focused on identifying the best aspects of each individual’s personal, academic, and professional journey while ensuring diverse and unique students join our community. Learn more about admissions at IE University, including who can apply and how we can assist and support you at each stage of the process.

Admissions

Discover the requirements you must meet to apply, the documentation you’ll have to submit, and the general timeline of the application process.

Financial aid

We offer a wide range of financial aid options, from awards to scholarships, flexible payment plans, and attractive financing options.

Student services

We're committed to making your time with us as seamless and stress-free as possible, so you can focus on studying and enjoying the IE experience.

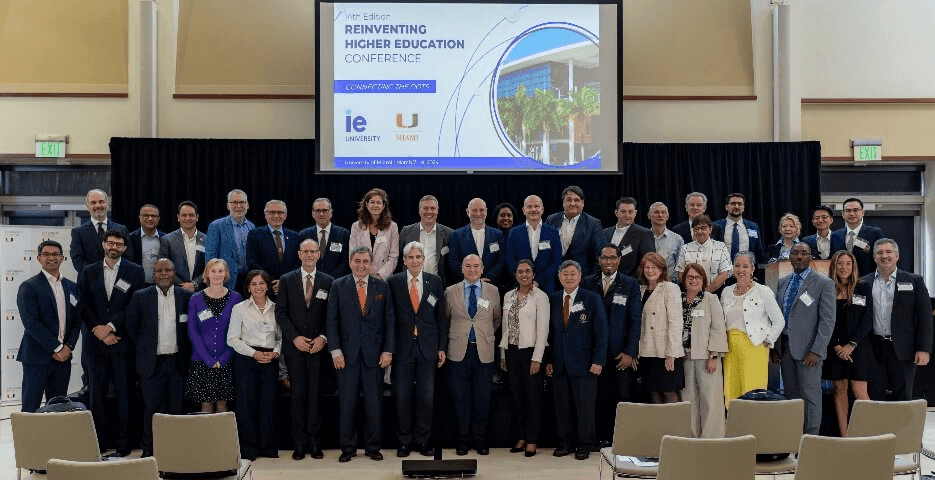

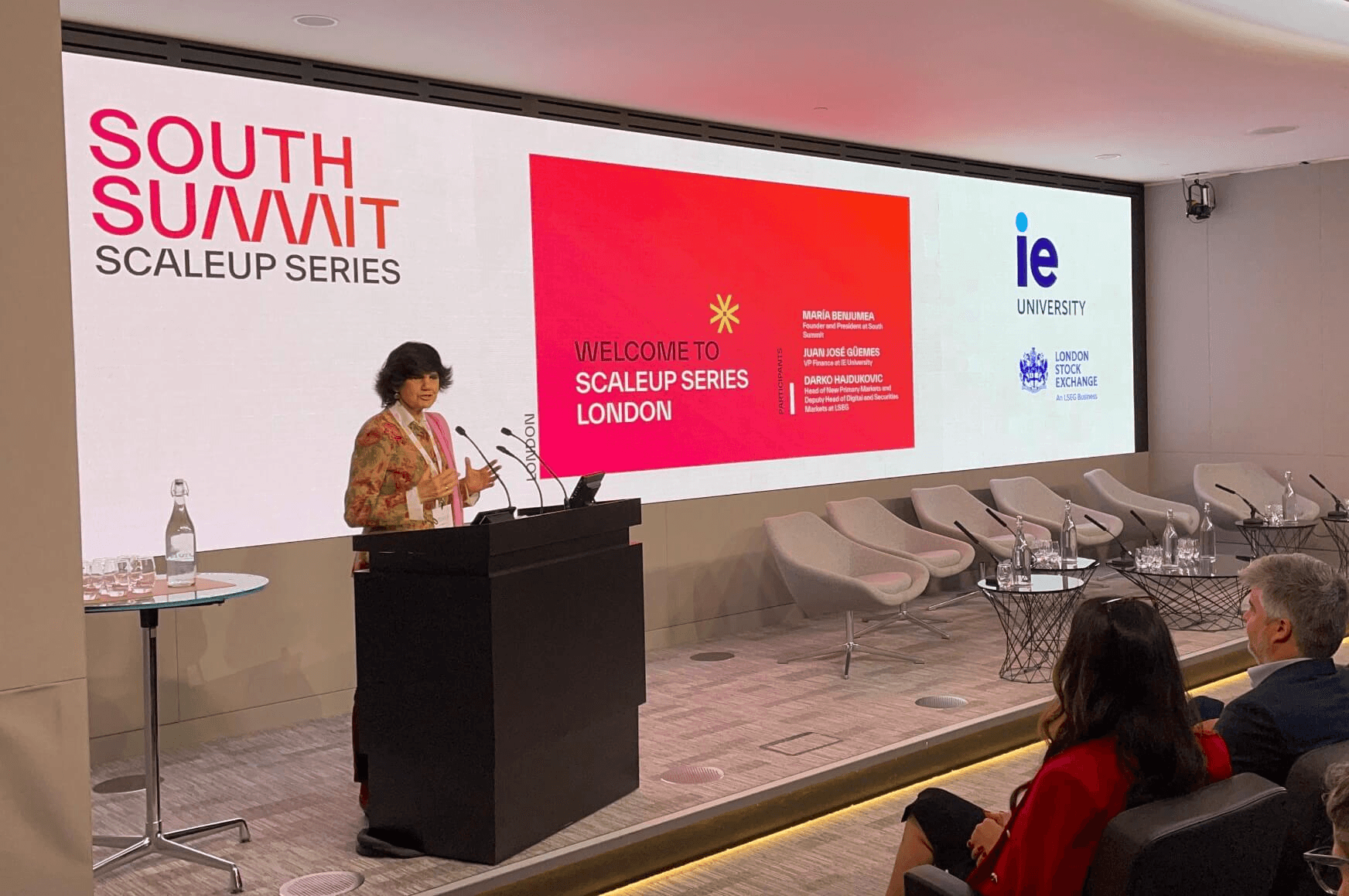

STAY UP TO DATE WITH OUR EVENTS

We organize over 1,500 events per year, from conferences to master classes, networking, and so much more.

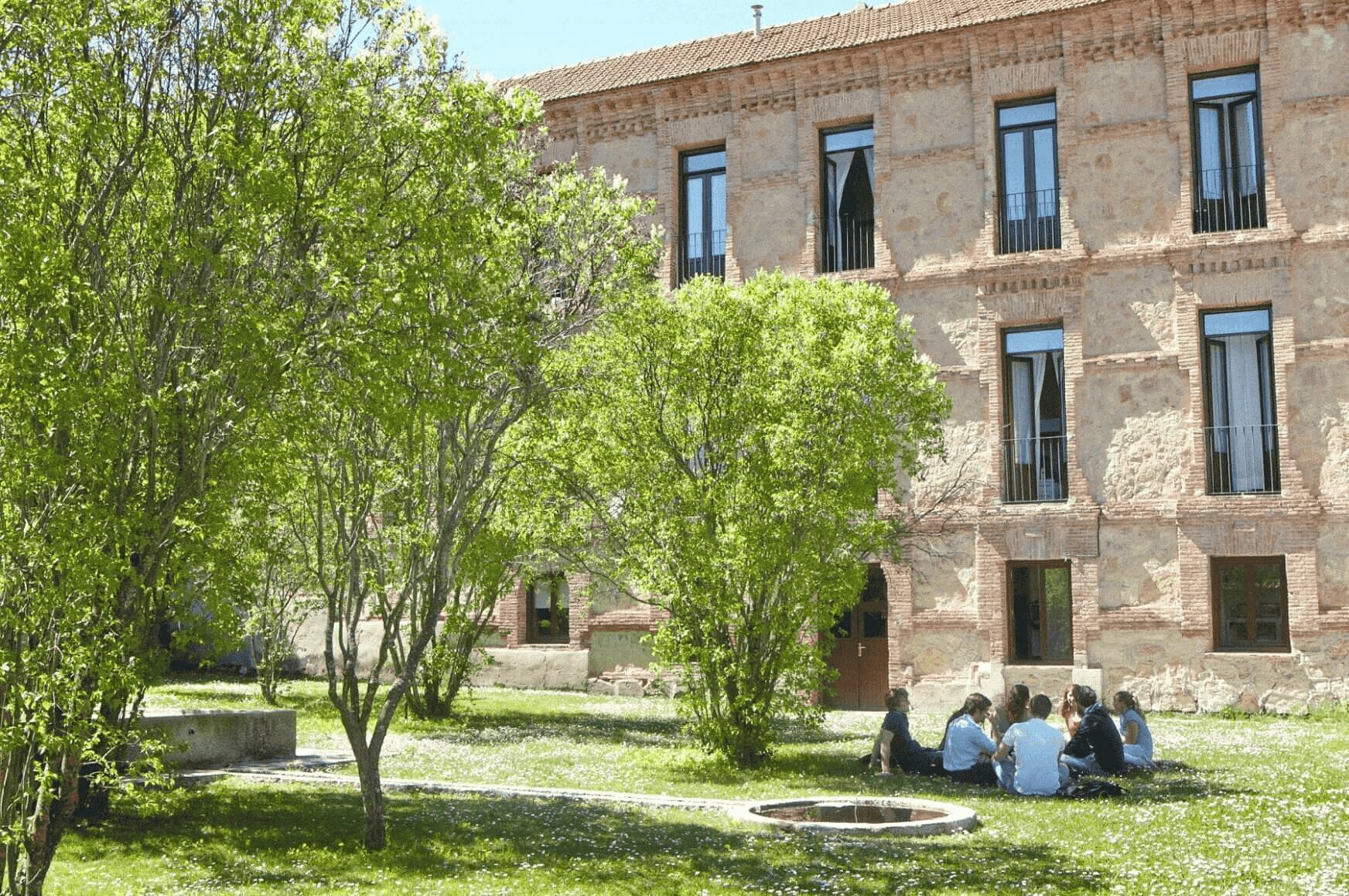

University in Madrid and Segovia

IE University has immersive on-site locations in two cities: fast-paced, cosmopolitan Madrid and the charming historic city of Segovia. Discover everything that each has to offer.

MADRID

There’s never a dull moment in the bustling capital of Spain. Get a feel for what student life is like at our fast-paced Madrid campus.

SEGOVIA

In Segovia, you’ll be enchanted by its winding cobblestone streets, breathtaking medieval castle, and grandiose historical sites. Dive in!

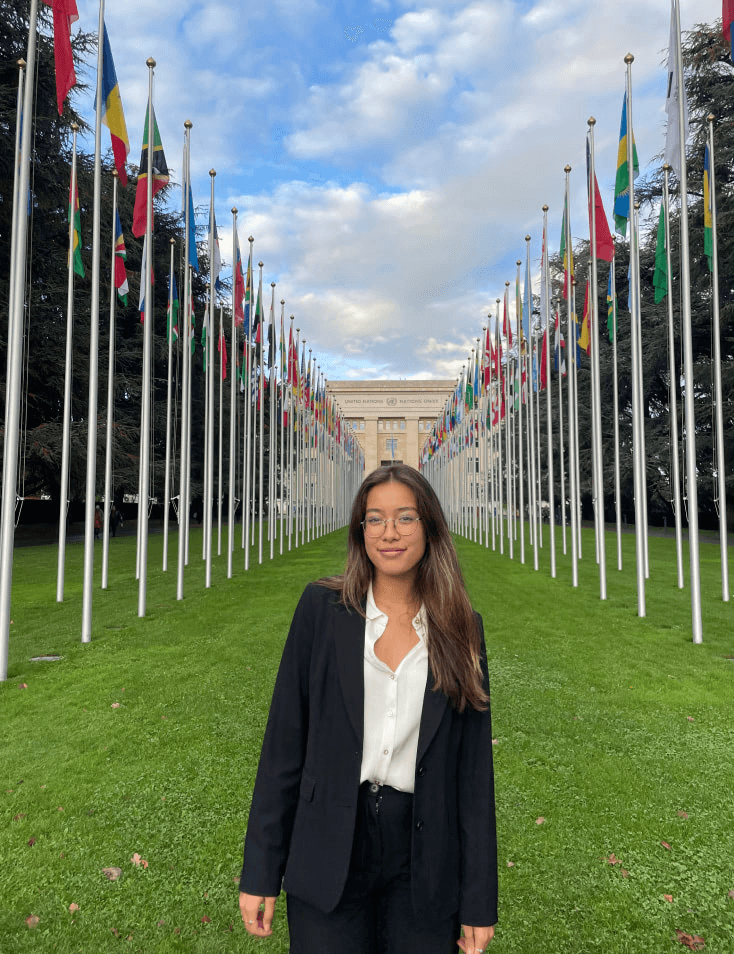

SUCCESS STORIES

Success isn’t one size fits all. Discover the unique academic and professional journeys behind our impressive community members.